- 6 次围观

2024-05-30 Hacker News Top Stories #

- TerminalTextEffects库为终端文本提供多种视觉特效,适合游戏而非日常工具。

- 华盛顿大学开发AI耳机,通过目标语音听觉技术,让用户在嘈杂环境中只听到特定说话者的声音。

- OpenAI前CEO Sam Altman因向董事会撒谎被短暂罢免,事件由前董事Helen Toner透露。

- 文章讨论API不应将HTTP重定向到HTTPS,因API主要被软件消费,与用户界面站点不同。

- Llama 3-V项目旨在构建开源GPT-4V竞争对手,模型小100倍,成本低,性能优异。

- Michael Lynch分享了他成功出售TinyPilot公司的经历,从不顺到以60万美元出售。

- Mistral AI发布首个代码模型Codestral,专为代码生成任务设计,帮助开发者编写和交互代码。

- Openkoda是一个开源商业应用平台,提供预构建功能,旨在减少开发时间和工作量。

- 加拿大政府提出议案C-26,希望拥有在网络中为监视创建秘密后门的权力。

- 文章总结了一年来使用大型语言模型(LLMs)构建的经验,预计推动AI领域投资增长。

TTE: Terminal Text Effects #

https://chrisbuilds.github.io/terminaltexteffects/showroom/

这个网站展示了一个名为 TerminalTextEffects 的效果库,包含各种文本特效及其默认配置。一些特效包括:

- Beams:在画布上创建光束,照亮字符。

- Binarypath:将字符解码为二进制形式,字符从画布外部朝向其输入坐标移动,以直角移动。

- Blackhole:在星空中创建黑洞,吸收星星,然后将输入数据爆炸回原位。

- BouncyBalls:字符从画布顶部以弹跳球的形式落下,最终定格在位置上。

- Bubbles:形成带有字符的气泡,气泡向下漂浮然后爆炸。

- Burn:字符被点燃并在屏幕上燃烧。

- 等等。

每种特效都有详细的配置和命令行参数。这个库提供了各种有趣的文本动画效果,可以为终端文本带来独特的视觉体验。

HN 评论 258 comments | 作者:makapuf | 1 day ago #

https://news.ycombinator.com/item?id=40503202

- 这个库的效果看起来很酷,但可能不适合用于日常工具中,更适合用于视频游戏。

- 有人提到这些效果可以用于老式的地牢类游戏。

- 有人提到类似效果在新的地牢类游戏 Cogmind 中也有应用,效果很棒。

- 有人提到这些效果可能会在 CLI 工具中成为默认输出,就像之前见过有人在野外使用 lolcat 一样。

- 有人表示终端的干净和简洁是终端的杀手功能之一,希望这些文本效果不会出现在真实应用中,除非与视频游戏相关。

AI headphones let wearer listen to a single person in a crowd by looking at them #

https://www.washington.edu/news/2024/05/23/ai-headphones-noise-cancelling-target-speech-hearing/

这篇文章介绍了华盛顿大学的一个团队开发的人工智能系统,可以让戴着耳机的人看着说话的人三到五秒钟来“注册”他们。这个系统名为“目标语音听觉”,可以在嘈杂的环境中取消所有其他声音,实时播放注册说话者的声音,即使听者在嘈杂的地方移动并不再面对说话者。

研究团队在人机交互计算系统 ACM CHI 会议上展示了他们的发现。这个系统的代码供其他人构建。该系统目前尚未商业化,但团队正在努力将其扩展到耳机和助听器。研究表明,测试对象对注册说话者的声音清晰度评分平均高出未经过滤的音频近两倍。这项工作建立在团队之前的“语义听觉”研究基础上,该研究允许用户选择他们想要听到的特定声音类别,并取消环境中的其他声音。

目前,TSH 系统一次只能注册一个说话者,只能在目标说话者的声音方向没有其他大声音时注册说话者。如果用户对声音质量不满意,他们可以再次注册说话者以改善清晰度。

HN 评论 376 comments | 作者:keploy | 18 hours ago #

https://news.ycombinator.com/item?id=40508278

- 如果耳机尺寸能缩小到小型耳塞的大小,我会喜欢使用这种产品,尤其是对于不患听力障碍的人来说。

- 有些人在拥挤场合无法听到任何人说话,可能是由于听力问题,也可能是大脑无法分辨声音。

- 餐厅和公共空间设计师停止考虑声音问题,导致大多数酒吧和餐厅变得嘈杂,这种设计选择可能会影响顾客体验。

- 有人提到了一种名为 Auditory Processing Disorder 的听觉处理障碍,可能会导致在嘈杂环境中难以听清楚。

- 有人分享了对于在吵闹场所难以听清的个人经历,以及使用特定耳塞来改善听力的建议。

- 有人讨论了餐厅和公共场所的声音设计问题,以及如何改善环境中的声音质量。

Ex-OpenAI board member reveals what led to Sam Altman’s brief ousting #

https://www.businessinsider.com/openai-board-member-details-sam-altman-lied-allegation-ousted-2024-5

根据 Business Insider 的报道,OpenAI 的前董事 Helen Toner 爆料称,前首席执行官 Sam Altman 曾多次向董事会撒谎,其中包括隐瞒公司所有权结构和在公司内部事务上提供不准确信息。

Toner 指控 Altman 多年来一直对董事会隐瞒信息,并对公司的安全程序进行了误导性描述。她表示,这种行为导致董事会无法信任 Altman,最终认定他不适合继续担任 CEO。

文章还提到,董事会在几次会议中听取了两名高管关于 Altman 的不良行为的描述,称其存在心理虐待行为,并认为他不适合领导公司实现人工智能的目标。最终,董事会决定罢免 Altman,但由于员工威胁要辞职并有传言称微软可能挖角 Altman 的团队,董事会在不到一周后恢复了 Altman 的 CEO 职务。

Toner 在 Altman 重返 CEO 职位不到两周后辞去了 OpenAI 董事职务。

HN 评论 696 comments | 作者:blackmanta | 22 hours ago #

https://news.ycombinator.com/item?id=40506582

- 评论中提到,OpenAI 董事会在决策中的实际权力远不及理论权力,真正的权力在于投资者和创始人的影响力;

- OpenAI 与其他公司不同,其价值几乎完全取决于研究人员、工程师和 Microsoft Azure 信用,而非实体资产;

- Microsoft 拥有基础设施,可以通过向研究人员提供大笔资金来招聘他们,这对 OpenAI 构成了挑战;

- OpenAI 缺乏长期合同、知识产权、基础设施和产品壕沟,使其在业界独特;

- 董事会在解雇 Altman 时未能提前准备好理由,导致沟通不畅;

- 职位权力与关系权力的区别被提及,引用《权力的游戏》中的台词;

- 评论中提到了权力、谣言、内部压力等因素对组织决策的影响。

API Shouldn’t Redirect HTTP to HTTPS #

https://jviide.iki.fi/http-redirects

这篇文章讨论了 API 不应该将 HTTP 重定向到 HTTPS 的问题。通常,当用户将其网络浏览器指向 HTTP URL 时,服务会将请求重定向到相应的 HTTPS 页面。然而,这种未加密的通信流程存在缺陷,因为共享网络中的第三方以及网络中介者可能会从初始的 HTTP 流量中嗅探密码和其他机密信息,甚至通过中间人攻击冒充 Web 服务器。文章指出,对于用户界面站点来说,采用重定向方法是有意义的,但有趣的是,重定向方法似乎也被广泛应用于 API。API 主要由其他软件消费,因此同样的可用性论点在这里并不适用。文章认为,由于这些因素,应重新考虑将 API 调用从 HTTP 重定向到 HTTPS 的常见做法。

文章还提到了一个实例,说明了即使发生简单的拼写错误,API 重定向也可能掩盖错误。在这个例子中,由于一个字母的遗漏,API 密钥以明文形式通过网络发送,这可能会导致 API 密钥被第三方获取而不被察觉。因此,文章主张采用“失败快速”原则,即不应该默默地跟随 API 重定向,而应以明显和可见的方式使未加密的 API 调用失败,以便开发人员能够及早发现和修复拼写错误。

最后,文章建议对 API 采取一种“失败快速”的方法,要么完全禁用 API 服务器的 HTTP 接口,要么对未加密的 HTTP 请求返回清晰的错误消息。这样可以确保开发人员能够快速注意到并修复意外的 URL,同时应该考虑通过未加密连接发送的 API 凭据被视为已泄露,并立即撤销它们。

HN 评论 278 comments | 作者:oherrala | 1 day ago #

https://news.ycombinator.com/item?id=40504756

- Stack Exchange API 曾经会在 HTTP 上撤销 API 密钥,这是一种处理方式。

- MITM 可能绕过撤销 API 密钥,但撤销策略有助于深度防御。

- 安全往往是实用的事务,即使无法解决所有问题。

- 在开发中禁用 TLS 是为了调试,但部署时不一定会启用。

- 部署中存在安全漏洞的可能性,因为操作者可能选择捷径。

- 部署人员可能会禁用 TLS,导致安全灾难。

- 通过硬件安全密钥或设备密码,安全认证实际上相当便利。

- 阻止 HTTP 请求可能无法防止主动 MITM 攻击。

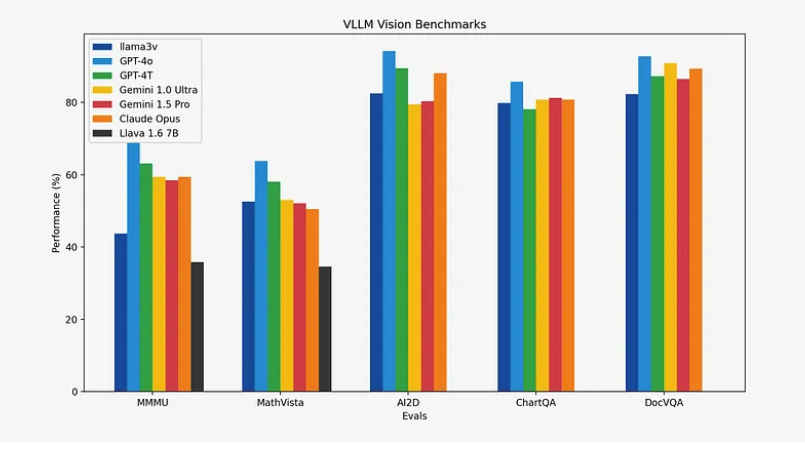

Llama 3-V: Matching GPT4-V with a 100x smaller model and 500 dollars #

这篇文章介绍了一个名为"Llama 3-V"的项目,旨在构建一个开源的 GPT-4V 竞争对手,其模型规模比 GPT-4V 小 100 倍,成本不到 500 美元。Llama 3 在多个基准测试中表现优异,甚至在某些方面超过了 GPT3.5 和 GPT4。为了应对 GPT4o 的挑战,作者发布了 Llama 3-V,这是第一个基于 Llama 3 构建的多模态模型。该模型在多模态理解方面比当前最流行的模型 Llava 有 10-20% 的性能提升,并在除 MMMU 之外的所有指标上与规模大 100 倍的封闭源模型相媲美。

文章详细介绍了 Llama 3-V 的模型架构、训练框架和系统优化。模型架构主要集中在使 Llama 3 理解视觉信息上,通过将输入图像嵌入到一系列补丁嵌入中,并通过投影块将这些嵌入与文本标记对齐,最终将视觉标记从投影块前置到文本标记中,然后将联合表示传递到 Llama 3 进行处理。为了优化计算资源,作者进行了两项主要优化:一是简单的缓存机制,二是 MPS/MLX 前端优化。

在训练方面,作者通过预计算 SigLIP 的嵌入来优化计算资源,并进行了 MPS/MLX 优化。在预训练过程中,他们使用预先计算的图像嵌入,并学习投影矩阵,然后在监督微调阶段,他们冻结计算的嵌入,并保持除视觉和投影矩阵之外的所有内容冻结。总的来说,Llama 3-V 的模型添加了一个视觉编码器,提供了 10-20% 的性能提升,并具有与规模大 100 倍的模型相媲美的视觉能力。文章还描述了在不到 500 美元的成本下进行预训练和指导微调的高效流程。

HN 评论 73 comments | 作者:minimaxir | 1 day ago #

https://news.ycombinator.com/item?id=40505099

- Llava 不是 SOTA 开放 VLM,InternVL-1.5 是,需要与强大的开放 VLM 进行比较,包括 CogVLM;

- 非常好奇它在 OCR 任务中的表现如何,需要与 InternVL 进行比较;

- CogVLM2 在 OCR 方面甚至比 Intern 更好(从发票中提取信息);

- MiniCPM 在 GUI 理解方面表现优于 InternVL;

- 与 InternVL 一样,缺少 llama.cpp 支持严重限制了其应用,接近 GPT4v 性能水平并可在任何机器上本地运行(无需 GPU)对于无障碍社区来说将是巨大的;

- 未来 15 年我将一直说“首次 AI 某事”以获取声望和资本,不会听取任何复杂的十步漏斗,如果他们没有做明显的事情;

- 与 MiniCPM-Llama3-V 2.5 相比如何?看起来比 Llama 3-V 在基准测试中要好得多,还可以直接在 Huggingface Spaces 上尝试以检查性能;

- 它在表格数据提取方面表现相当不错,想知道如何用于长文档,也许可以与某种混合 rag 方法配对使用;

- GPT4-V 在视觉任务中的生产中是否有人使用过?对我来说从未足够一致以便有用;

- 对于 GUI 段理解非常可靠,可以查看 https://github.com/OpenAdaptAI/OpenAdapt/pull/610;

- 它可以用于自动注释吗?您告诉它这些部分应该被屏蔽,然后它会这样做吗?我们对此并没有成功;

- 不要将其用于需要完美准确性的 OCR 相关内容,对一些允许出现错误的内容,我们取得了很大成功;

- 与 Tesseract 相比如何?Tesseract 在这一点上几乎过时了,对于需要良好准确性或轻微复杂性的任何内容都不是一个严肃的技术;

- Tesseract 的真正价值在于只需一个 apt-get 命令(即开源),Debian 的存储库中是否有更现代的 OCR 系统?

- Tesseract 工具只是一个 apt-get 命令,但训练模型不是,它们只是一个起点,而不是最终目的,你仍然需要在其上进行更多的训练;

- 我对 OCR 工作做了很多工作,Tesseract 在这一点上几乎过时了,如果您想要快速而功能强大的 OCR,请查看 paddle,如果您想要更慢但更高准确性的 OCR,请查看基于 transformer 的模型,如 TrOCR。

I sold TinyPilot, my first successful business #

https://mtlynch.io/i-sold-tinypilot/

这篇文章讲述了作者 Michael Lynch 关于他成功出售 TinyPilot 公司的经历。文章首先回顾了 Michael 作为自主创业者的最初两年并不顺利,但在 2020 年中期,他制作了一个名为 TinyPilot 的小装置,用于通过网络浏览器远程控制家中的服务器。TinyPilot 迅速受到关注,销售一空,成为 Michael 的第一个成功的产品。

随后,文章描述了 Michael 全职致力于将 TinyPilot 打造成一家公司并不断改进产品的四年经历,公司规模扩大到七人团队,年收入达到 100 万美元。最终,Michael 在一个月前以 60 万美元的价格出售了公司。

文章详细介绍了销售过程中的细节,包括销售价格、经纪佣金、法律费用以及 Michael 从销售中获得的利润。Michael 还分享了销售前的准备工作、寻找买家的过程以及最终达成交易的经历。

最后,文章提到了 Michael 在出售后的感受,他描述了交易完成后的第一件事是吃甜点,并分享了他对未来的计划,包括准备迎接第一个孩子、寻找新的项目以及希望通过博客吸引客户并从中获益。文章以对 TinyPilot 的未来展望结束,指出新业主 Scott 计划继续改进产品并扩大受众群体。

HN 评论 132 comments | 作者:mtlynch | 7 hours ago #

https://news.ycombinator.com/item?id=40512500

- 买家和卖家在交易中都有风险和损失,交易失败后双方都会受损。

- 交易和结束费用可能占销售总价的 18%。

- 创业中的痛苦可能源于同时从事硬件、软件和电子商务。

- 一些人认为创业容易,但实际上创业困难重重。

- 代理费用可能高于预期,取决于卖家能否自行谈判。

- 代理商在定价、策略和吸引潜在买家方面发挥着重要作用。

- 通过书籍学习一些知识是有帮助的,但实践经验和专业指导也至关重要。

- 买家通常会承担贷款,而不是卖家。

- 作者通过代理人找到了买家,代理人在整个过程中提供了指导和帮助。

- 作者在准备出售公司时调整了策略,避免了长期投资回报。

- 作者计划未来从事教育产品或 SaaS 业务,注重快速测试和寻找付费客户。

- 作者认为自主和独立性比在公司工作更重要,因此选择了创业。

- 作者在硬件创业中取得成功,但意识到硬件行业的风险和挑战,表示不会再次从事硬件创业。

- 作者在销售公司后没有后悔,更看重自主权和个人成长。

- 作者在销售公司时考虑了家庭因素和个人压力,决定放弃创业。

- 作者在销售公司后计划减少工作时间,享受家庭生活。

- 作者通过 TinyPilot 项目学到了很多经验教训,包括早期推出产品和与受众相关的产品。

- 作者在销售公司时遇到了挑战,但最终取得成功,展示了创业之路的曲折和收获。

- 作者通过销售公司获得了成功,展示了创业之路的挑战和成就。

Codestral: Mistral’s Code Model #

https://mistral.ai/news/codestral/

这篇文章介绍了 Mistral AI 推出的首个代码模型 Codestral。Codestral 是一个开放权重的生成式人工智能模型,专门设计用于代码生成任务。它帮助开发人员通过共享的指令和完成 API 端点编写和交互代码。Codestral 精通 80 多种编程语言,包括流行的 Python、Java、C、C++、JavaScript 和 Bash 等,也能很好地处理像 Swift 和 Fortran 这样的特定语言。Codestral 可帮助开发人员节省时间和精力,完成编码功能、编写测试,并使用填充中间机制完成任何部分代码。与其他用于编码的模型相比,Codestral 在性能/延迟空间上树立了新的标准,具有更大的上下文窗口,表现优异。

Codestral 还提供了两种使用端点的方式:codestral.mistral.ai 和 api.mistral.ai。codestral.mistral.ai 适用于使用 Instruct 或 Fill-In-the-Middle 路由的用户,而 api.mistral.ai 更适合研究、批量查询或直接向用户提供结果的第三方应用程序开发。此外,Codestral 还可以通过 Le Chat 与开发人员进行自然直观的交互,以利用模型的功能。Codestral 还与多种应用程序框架和开发环境集成,如 LlamaIndex、LangChain、VSCode 和 JetBrains,使用户能够轻松构建应用程序。

该文章还引用了一些开发人员和研究人员对 Codestral 的评价,他们对其性能和效果表示了高度赞赏。Codestral 的发布被认为是代码生成领域的一次重大突破,为开发人员提供了更高效、更准确的编码辅助工具。

HN 评论 148 comments | 作者:alexmolas | 7 hours ago #

https://news.ycombinator.com/item?id=40512250

- 许可证禁止将模型及其输出用于任何商业活动,甚至任何“实时”(不管是什么意思)条件下,商业或非商业。

- AI 公司生活在玻璃房子里,不能抛出知识产权的石头,否则会破坏他们自己的“您的内容是我们的训练数据”基础。

- AI 公司的问题是,他们不能在没有自己的“您的内容是我们的训练数据”基础的情况下抛出知识产权的石头。

- 他们已经采用了我的代码,现在正在规定我如何使用他们的衍生作品。

- Mistral 是尽可能开放的,大多数其他公司更糟糕。在这里,您可以使用模型而无需担忧,正如其他人所说,如果您在商业应用程序中使用模型生成的代码,他们不太可能起诉您。

- 企业自杀文化。

- 在许多国家,您甚至不能声称对 AI 的输出拥有版权,以使用这样的许可证。

- 版权软件产生的东西并不等同于对输出的版权。

- 一个足够细分的提示实际上就是代码本身。

- 我通常会提供一些复杂的 Rust 代码,并要求他们修复它。LLMs 通常无法为此提供太多帮助,除非是一些非常基本的情况。

- 这是一个开放权重的 22B 模型。在本地运行它需要多少 RAM?

- 22B 参数* 2 字节(FP16)= 44GB 仅用于权重。这不包括 KV 缓存和其他内容。

- 22B 参数* 2 字节= 44GB 仅用于权重。这不包括 KV 缓存和其他内容。

Show HN: Openkoda – Open–source, private, Salesforce alternative #

https://github.com/openkoda/openkoda

这个 GitHub 仓库地址 https://github.com/openkoda/openkoda 是一个开源的商业应用平台,旨在快速开发应用。该平台提供了预构建的功能和开箱即用的特性,可帮助减少开发时间和工作量。使用 Java、Spring Boot、JavaScript、HTML、Hibernate 和 PostgreSQL 等技术,支持灵活可扩展的应用开发,包括动态实体、多租户模型等功能。

同时,Openkoda 还提供了集成、用户管理、角色权限、组织管理、CMS、资源管理、事件监听器、备份、导入导出、作业请求、通知等功能,以及示例应用模板和合作伙伴计划。详细的安装指南和功能说明可在该仓库中找到。

HN 评论 108 comments | 作者:mgl | 1 day ago #

https://news.ycombinator.com/item?id=40502956

- 有评论指出 Openkoda 需要更全面的文档,特别是开发者文档,以便更好地支持定制和开发。

- 有人表示使用 Odoo 并喜爱它,但指出 Odoo 生态系统复杂,文档不足,可能浪费时间。

- 有评论提到 Openkoda 不是 Salesforce CRM 的直接替代品,而是更适合构建核心业务应用,保留完整源代码所有权,避免依赖大型 S 公司技术和商业限制。

- 有人提到有人使用 Ofbiz 替代 Salesforce,因为 Ofbiz 灵活且真正开源,允许快速建模和构建任何内容。

- 有人关注 Openkoda 的 UI,认为界面可能影响用户体验,希望有更现代化的 UI/UX。

- 有评论指出 Odoo 类似于 OpenKoda,但 Odoo 在企业市场表现良好,提到 Odoo 创始人成为比利时最年轻的亿万富翁。

- 有人批评 Odoo 的商业化方式,认为开源版本与企业版本之间的差异过大。

- 有人讨论了 Salesforce 的合作伙伴生态系统,指出 Salesforce 避免与合作伙伴生态系统中的软件/服务竞争。

- 有人提到 Openkoda 欢迎服务/技术合作伙伴,允许构建应用程序或扩展。

- 有人质疑 Openkoda 的最新提交时间,询问是否仍在开发中。

- 有评论讨论了 Java 作为 Openkoda 的编程语言选择,认为 Java 具有高质量的库、高效的运行时和静态类型,易于重构。

Ottawa wants the power to create secret backdoors in networks for surveillance #

这篇文章讨论了加拿大政府提出的一项涉及网络安全的法案,即议案 C-26,其中包含秘密的、破坏加密的权限,政府并不愿意公开讨论这一点。

该法案赋予政府官员秘密命令电信公司在加拿大网络中安装后门的权力。这可能包括要求电信公司修改保护移动通信的 5G 加密标准,以便进行政府监视。文章指出,政府推动这项提案法律而不修改以删除这种破坏加密的能力,引起了人们的警惕,认为这些新权力是一种特征,而不是错误。

文章还提到了当前网络中存在许多不安全因素,包括通信技术基础设施层面的不安全性。加拿大政府寻求创造更多漏洞的能力,而不是修补它们,这似乎毫无道理。新的权力将使加拿大人更容易受到对网络用户隐私和安全构成威胁的恶意威胁。

文章还指出,历史上政府后门暴露了个人深层次的网络不安全性,这可能被执法机构、犯罪分子和外国对手利用。最后,文章呼吁加拿大需要明确承认未受损害的加密是网络安全的基石,并应尽一切可能的方式进行规定和保护。

HN 评论 187 comments | 作者:walterbell | 7 hours ago #

https://news.ycombinator.com/item?id=40512509

- 加拿大有权为监视而在电信网络中设置后门,但实际上他们想要在没有法律监督或传统法律门槛(如令状)的情况下实现这一目标。

- 个人隐私急剧下降,国家安全局等间谍机构几乎可以轻松获得他们想要的所有电子通信,而国内执法机构获得新的方式来消除令状要求等摩擦。

- NSA 和地方警察之间的区别在于,NSA 不会寻找借口逮捕或骚扰你,而地方警察可能会。

- 他们不会寻找借口逮捕或骚扰你,但他们会寻找你的裸照。

- 拖网监视不是为了打扰你的嗜好,而是为了获取对那些重要的一万名议员的黑材料。

- 他们拖网监视以获取对重要议员的黑材料,记者,可能想要吹哨的人,知晓商业机密的人等。

- 他们利用这些信息来控制/影响政府官员或有权力的人。

- 除非你是发布联邦政府不喜欢的信息的记者,否则他们将无限期监禁你而不经审判。

- NSA 比地方警察更有能力,监督更少(尽管警察的监督和问责度也不高)。

- 加拿大自 1982 年以来并没有(真正的)宪法,因为自 1982 年以来的 TP 有一个“不管”的条款,意味着议会可以无视他们的《权利法案》的等同。

- 加拿大有《权利与自由宪章》,但甚至像财产权或自卫权这样的基本事项甚至都没有提及,而那些被描述的事项,描述得模糊,所以整个宪章的价值不值得它所印刷的墨水。

- 加拿大已经有合法拦截。

- 加拿大政府议员坚称他们的意图不是扩大监视能力。

- 他们利用这些信息来控制/影响政府官员或有权力的人。

What We Learned from a Year of Building with LLMs #

https://www.oreilly.com/radar/what-we-learned-from-a-year-of-building-with-llms-part-i/

这篇文章总结了一年来使用大型语言模型(LLMs)构建的经验和教训。LLMs 在真实世界应用中变得“足够好”,并且随着 LLMs 的不断改进,社交媒体上的一系列演示将推动到 2025 年 AI 领域的预计 2000 亿美元投资。

LLMs 具有广泛的可访问性,使每个人都能将智能集成到其产品中。文章提到了一些关键但常被忽视的机器学习概念和方法,这些对于基于 LLMs 开发产品至关重要。作者们分享了他们在过去一年中构建基于 LLMs 的真实应用时所学到的经验和教训,包括关于提示、检索增强生成、流程工程、评估和监控的最佳实践和常见陷阱。

文章还探讨了如何设计人机协作工作流程,以及如何优化和构建可靠的 LLM 工作流程。文章分为战术、运营和战略三个部分,这是其中的第一部分,着重介绍了与 LLMs 工作相关的战术方面。

文章提到了一些关键的提示,如提示技巧、评估策略、检索增强生成思路等,以帮助构建和交付强大的 LLM 应用。文章还提到了 LLMs 的评估和监控,以及如何处理 LLMs 可能出现的问题,如幻觉、事实不一致等。

HN 评论 80 comments | 作者:7d7n | 17 hours ago #

https://news.ycombinator.com/item?id=40508390

- LLM 采样分布,单次采样不代表分布代表性,多次采样投票效果高,但慢;评估提示需多次运行,单次无价值。

- 生成序列有顺序,决策和理由顺序生成无意义;决策前理由效果更好,LLM 无法违反因果关系。

- Beam search 是从语言模型采样的好方法,OpenAI 目前不支持,希望添加支持。

- 提供多个视角让模型回答问题,结合结果在提示中,有效。

- 评估提示需多次采样,一次无法判断提示质量,多次可控制错误率。

- 分解任务为小子任务,每步不需要完整上下文时,使用自定义提示/模型更好。

- 评估 LLM 输出性能的好指标?难以量化,但在损失函数中可能有。

- LLM 输出性能评估需多次采样,一次不足以评估。

- 使用温度 0 采样一次可避免错误,例如“Pete”每次输出。

- 评估提示需多次采样,一次无法判断提示质量,多次可控制错误率。